Kunstig intelligens

I bund og grund forstår ChatGPT ikke noget

Chatbotten ChatGPT har sat gang i en storm af diskussioner om, hvad kunstig intelligens kan betyde. Samtalen er dog ikke ny, og lektor Nikolaj Nottelmann giver her filosofisk indblik i, hvad kunstig intelligens kan – og bestemt ikke kan.

I 1950 forudsagde den britiske matematiker og filosof Alan Turing, at det om få år ville blive en overflødig diskussion, hvorvidt en maskine var intelligent eller ej.

Han introducerede Turing-testen. Kort fortalt går den ud på at vurdere, hvorvidt en maskine er intelligent eller ej ud fra, om man gennem en skriftlig samtale mellem et menneske og en maskine kunne afgøre, om det var en maskine.

En moderne sprogmodel som ChatGPT viser, at Turing-testen ikke er fair overfor maskinen. For ChatGPT afslører med det samme, at den ikke er menneske, fordi den så hurtigt kommer med meget fyldestgørende svar på komplicerede spørgsmål.

Mangler dyb forståelse

Det kan forlede folk til at tro, at det er en overmenneskelig intelligens. Men det kan man ikke konkludere, understreger lektor og ph.d. i filosofi, Nikolaj Nottelmann. Maskinen er ekstrem inden for induktiv slutning og sammenfatning af mønstre i store informationsmønstre.

- Det får nogle til at falde på halen, fordi det også er nogle af de evner, man traditionelt forventer af et begavet menneske. Men den mangler noget helt essentielt: evnen til at vise en dybere forståelse og til at tænke i radikale begrebslige brud, forklarer Nikolaj Nottelmann.

Turing fokuserede på, hvad computeren kunne producere, men det centrale er, hvordan den gør det, påpeger han.

Sprogmodellen ChatGPT bygger på neurale netværk. Det vil sige, at den bruger en række matematiske operationer til at bearbejde og analysere en enorm mængde data. Den er i stand til at lære fra erfaring ved at justere vægtningerne af forbindelserne i sin kunstige hjerne.

Den udvikler sig med andre ord – eller bliver klogere kunne man tro.

Ekstrem til mønstergenkendelse

Dens exceptionelle evner til at trække på viden og genkende mønstre og dermed formulere formfuldendte sætninger om komplicerede emner, imponerer os.

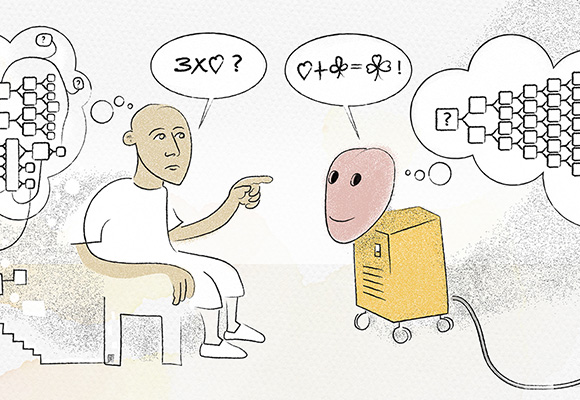

Men netop mønstergenkendelsen begrænser den også i forhold til spørgsmålet om intelligens. For i bund og grund forstår den ikke noget. Den gengiver bare det, den på baggrund af sit enorme bagkatalog anser for det mest sandsynlige, forklarer Nikolaj Nottelmann.

Han sammenligner ChatGPT’s viden med den viden, som de fleste mennesker har om komplicerede emner, for eksempel Einsteins relativitetsteori. Vi har forstået, at det er en vigtig og korrekt teori, men vi forstår ikke teoriens indhold.

Når ChatGPT kan forklare komplicerede emner, sker det på baggrund af data, som den gengiver, og den kan dermed bestå svære eksaminer i paratviden. Men den besidder ikke en grundlæggende forståelse af emnet.

”Folk, der vil sprede misinformation, kan jo gøre det langt mere effektivt ved hjælp af nogle robotter. Fordi robotterne kan skræddersy deres budskaber til enkeltpersoner.

- Den regner kun i sandsynligheder. Når du spørger den om noget, går den igennem sit datasæt og svarer: "Er det sandsynligt, at dette er sandt, ud fra de mønstre, jeg kan finde her?" Det er det eneste, den kan, understreger Nikolaj Nottelmann.

At den på den måde gengiver forklaringer, som virker acceptable, kan føre til noget værre skidt.

For eksempel blev Metas sprogmodel taget ned to dage efter lanceringen i august 2022. I sin bearbejdning af data havde den vægtet antisemitiske oplysninger og gav derfor antisemitiske svar, ligesom den hævdede, at Donald Trump for altid ville forblive præsident i USA.

Den kunstige intelligens’ indbyggede mønstergenkendelse er på en gang dens styrke og den svaghed – hvis man sammenligner med menneskelig intelligens. Idet den bygger al sin viden på mønstre, kan den ikke bryde ud af disse mønstre.

En induktiv beslutningsmaskine

Det er væsensforskelligt fra menneskers forestillingsevne, som let kan ændre forudsætningerne for en beslutning. Maskinen er, hvad man videnskabsteoretisk vil kalde en induktiv beslutningsmaskine, fortæller Nikolaj Nottelmann.

- Den kan sætte data ind i et allerede eksisterende mønster, men den er ude af stand til at tænke over, hvad der kunne ske, hvis mønstret radikalt ændrer sig i fremtiden, eller hvis nogen satte et andet mønster ind, forklarer Nikolaj Nottelmann.

Af samme årsag er Nikolaj Nottelmann ikke bekymret for en fremtid, hvor maskiner overtager styringen, uden at vi mennesker har programmeret den til det. For den kan ikke tænke sig til sådan et nybrud.

- Hvor skulle de teoretiske gennembrud komme fra, som skulle muliggøre det? Det kan den principielt ikke tænke sig frem til, medmindre principperne for at konstruere sådanne robotter mirakuløst gemmer sig i den allerede bestående viden, siger han.

Misinformation og troldekampagner

Til gengæld sætter ChatGPT og dens digitale kolleger vores forhold til viden endnu mere på spidsen, end det allerede er.

- Folk, der vil sprede misinformation, kan jo gøre det langt mere effektivt ved hjælp af nogle robotter. Fordi robotterne kan skræddersy deres budskaber til enkeltpersoner, siger Nikolaj Nottelmann.

Sprogmodeller som ChatGPT er programmeret til at kommunikere som mennesker, hvilket får mennesker til at sænke paraderne.

- De, der misinformerer, kan udnytte menneskers naturlige tillid. Jeg tror slet ikke, vi er klar til at håndtere de misinformationskampagner, vi bliver udsat for i fremtiden - hverken individuelt eller kollektivt - og jeg ved heller ikke, hvordan vi skal opgradere os selv hurtigt nok, siger Nikolaj Nottelmann.

”De, der misinformerer, kan udnytte menneskers naturlige tillid. Jeg tror slet ikke, vi er klar til at håndtere de misinformationskampagner, vi bliver udsat for i fremtiden - hverken individuelt eller kollektivt.

Han tror ikke på opfordringen fra over 1.000 forskere og tech-moguler om at sætte udviklingen af kunstig intelligens på pause i et halvt år. Der vil altid være nogen, som ikke respekterer sådan en pause.

- Jeg tror personligt, at vi har været alt for naive i forhold til sociale medier, og nu er alle sluser åbne. På nogle dage ser jeg det som bedste måde at håndtere det på, at vi lukker ned fra stort set alle sociale medier. Vi har jo levet fint uden før, siger Nikolaj Nottelmann.

Til gengæld ønsker han ikke at lukke for adgangen til Chatbots som ChatGPT, for de kan bruges til meget godt.

- For eksempel har Khan Academy udviklet en chatbot til at føre sokratiske samtaler med studerende. Det vil sige, den formidler ikke bare informationen til de studerende, den opfordrer dem til selv at tænke sig frem til ting, siger Nikolaj Nottelmann.

Mød forskeren

Nikolaj Nottelman er lektor og ph.d. i filosofi. Han forsker især inden for erkendelsesteori og metafysik.